Il mio AI Tech Stack 2025: strumenti AI per sviluppatori e consulenti

Nel 2025 l’AI non è più un “extra”, ma parte integrante dello stack di lavoro di ogni sviluppatore. In questo articolo racconto gli strumenti AI-based che ho realmente usato come consulente informatico, spiegando perché li ho scelti, come li combino e in che modo mi permettono di lavorare meglio, più velocemente e con costi sostenibili.

Nel 2025 la domanda non è più stata “usi l’AI per programmare?”, ma: quale combinazione di strumenti ti fa consegnare di più, con meno errori e senza pagare due volte la stessa cosa? Questo articolo è il mio stack AI 2025 “reale”: IDE agentici, agenti in terminale, estensioni, e soprattutto un livello che ha cambiato il gioco: MCP (Model Context Protocol), la colla che collega l’AI a browser, documentazione aggiornata e project management.

Perché nel 2025 non conta “usare l’AI”, ma lo stack

L’AI ti può far scrivere codice più in fretta… oppure farti perdere ore in tre modi molto “silenziosi”:

- Duplicazione: paghi due abbonamenti che fanno lo stesso pezzo (autocomplete + chat + agent) e rimbalzi le richieste tra le varie app;

- Contesto instabile: l’assistente lavora “a intuito”, sbaglia file, sbaglia versione di API, e tu fai babysitting, con conseguente spreco di token;

- Costo invisibile: iterazioni infinite, modelli troppo grandi su task banali, agenti lasciati liberi di provare mille strade, con output di scarsa qualità.

Il punto è semplice: lo stack è una scelta di prodotto, non una collezione di tool. Devi progettare flusso, guardrail e budget insieme per evitare di cadere in questo limbo di errori che ti costano stress e, sopratutto, denaro.

Il mio stack 2025 in una riga

- Cursor → IDE principale (UI minimal + AI integrata davvero bene)

- OpenAI Codex → backend, problem solving, debugging, refactor “pesanti”

- VS Code + GitHub Copilot → base universale / fallback compatibile ovunque

- MCP → Chrome DevTools, Context7, Linear per chiudere il loop “codice → verifica → task”

Questo rappresenta non solo la combinazione che ho usato di più ma anche quella che prevedo di usare per il 2026 per ragioni di miglior rapporto qualità/prezzo. Costi contenuti, perfomance elevate e stravolgimenti rispetto il lavoro ordinario, assenti.

Cursor IDE: la menzione speciale (l’IDE che “sparisce”)

Se nel 2025 sono esplosi IDE “AI-first”, Cursor è quello che più spesso mi ha dato la sensazione di: “sto lavorando in un editor familiare, ma con superpoteri”.

Chat + inline edit: integrazione vera

Il vantaggio pratico è l’attrito più basso: chat, modifiche in linea, azioni “agentiche” e contesto convivono senza farti cambiare modalità mentale ogni due minuti. Puoi saltare dalla chat agentica alla modalità “Ask” fino a quella inline in modo sinergico e senza rischiare di perdere il flusso.

Cursor ti permetta nella stessa chat di passare alla modalità blindata al solo read per fare brainstorming costruttivo che puoi usare, una volta passato su Agent, come base di conscenza per fare vibe coding di qualità. Anche la parte dell'inline edit a differenza dei molti tool/ide sul mercato sembra essere in grado di produrre risultati soddisfacenti e quasi sempre in linea con quello che stavi pensando.

Non ho informazioni verificate ma posso dedurre che il contesto fornito al modello usato dall’inline edit non sia semplicemente quello relativo a poche righe su e giù del foglio, ma a una commistione di elementi tra cui: contesto file recentemente modificati e la chat attiva in quel momento.

@mentions: il trucco anti-“AI che indovina”

Questa è la leva che mi ha dato il boost più costante. Le @mentions servono a portare in chat esattamente ciò che conta: file, cartelle, documenti “source of truth”.

Checklist di cose che menziono spesso:

- file chiave (route, service, componente UI)

- cartelle tipo src/components, app/, packages/

- snippet di config, README, note interne

Il risultato è quello di ottenere meno risposte “creative”, più risposte ancorate al codice vero. Le menzioni inoltre ti permettono di cambiare contesto rapidamente nella stessa chat, quando magari si ha bisogno di mantenere una parte di ciò che si è affrontato nell’ultima sessione senza dover anticipare nuovamente informazioni sul prompt.

Rules: la memoria operativa del progetto

Le Rules sono il mio anti-caos: convenzioni, architettura, stile, vincoli. Cursor le descrive come istruzioni “di sistema” per l’agente, condivisibili e riutilizzabili.

Nonostante vengano usate, come testimonia questa repository, per fornire maggior precisione e perimetro d’azione al modello, l’ho trovata molto efficacie anche per caricare interi PRD (Product Requirements Document) e lasciando decidere a Cursor quando applicare la regola. Da qualche tempo è disponibile anche un generatore di project rules che ti permette di creare ciò che serve davvero in relazione alle tue esigenza

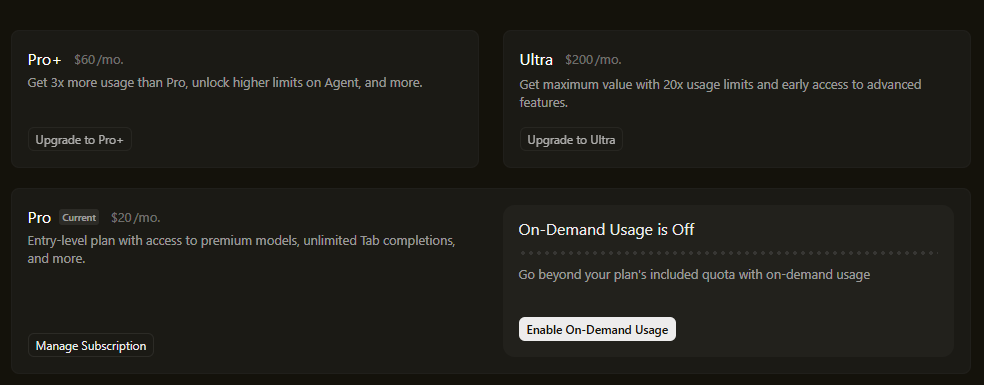

Costi Cursor: come ragiono sul piano

Cursor mostra chiaramente il Pro a $20/mese. La cosa importante non è “quanto costa”, ma quando lo usi:

- Task cheap (autocomplete, piccole modifiche) → ok, spingi.

- Task costosi (agent che analizza mezzo repo) → prima prepari contesto e regole, poi chiedi.

Inutile dire che il piano Pro (il piano principale) a circa € 20,00 al mese risulta poco utilizzabile in un contesto professionale se si fa un uso eccessivo come tool di vibe coding. Questo piano necessità di un approccio molto più da dev che da vibe coder. I task vanno organizzati sapientemente cercando di evitare gli attuali modelli di punta come Opus4.5 o GPT5.2 che possono consumare tanti token solo per il reasoning. Questo piano è perfetto per chi scrive per lo più codice in autonomia, sfruttando a pieno l’inline code e gestendo le task a livello agentico a piccole dosi; richiede inoltre una discreta conoscenza dei modelli perché diventa fondamentale, fin da subito, usare quello corretto per il caso d’uso specifico.

Bisogna dire che Cursor ha rilasciato anche la funzione Auto per la selezione del modello portando indubbiamente a comprimere i costi e l’utilizzo di modelli costosi senza un giusto crietrio ma la nota dolente è che non si sa quale LLM è in uso in quel momento. Probabilmente l’approccio migliore è quello di far eseguire in automatico solo task molto precisi e di breve durata evitando quindi di derogare “troppo” al modello che per quanto se ne sa potrebbe essere un AI proprietaria ma anche un GPT 4.o, decisamente indietro in termini di perfomance e precisione rispetto ai modelli più recenti.

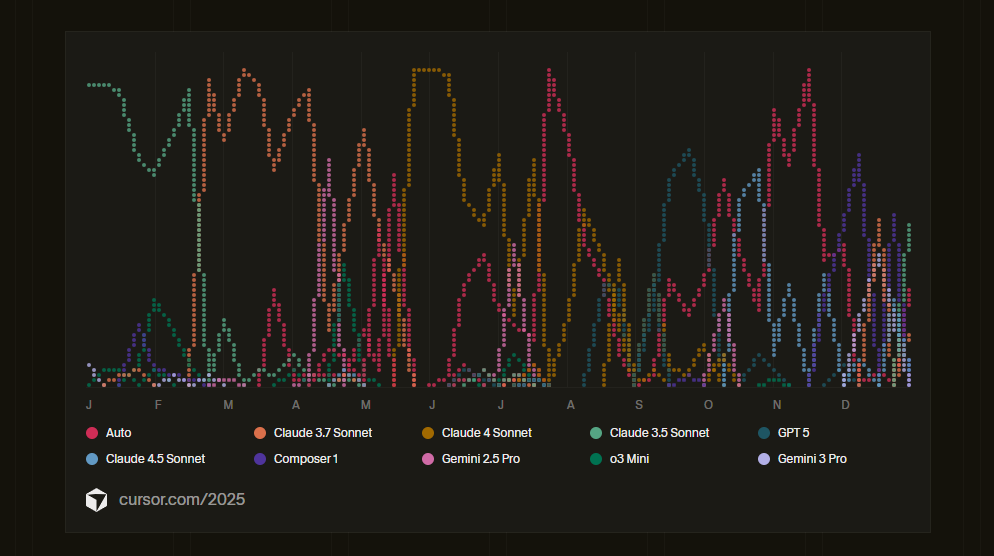

Il mio uso dei modelli è cambiato radicalmente durante il corso dell’anno e il wrapped di Cursor ha ben raccontato il flusso:

OpenAI Codex in ChatGPT: il miglior rapporto qualità-prezzo (nel mio 2025)

Io qui sono netto: quando devo fare architettura, debugging vero o refactor grossi, Codex in ChatGPT mi ha ridotto il ping-pong.

OpenAI lo descrive Codex come un agente di coding disponibile in più contesti (terminal, IDE, GitHub, cloud) e incluso nei piani ChatGPT Plus/Pro/Business/Edu/Enterprise. E nella pagina Codex è indicato, ad esempio, Plus a $20/mese e Pro a $200/mese (con limiti più alti).

Di fatto Codex è disponibile via CLI e anche sottoforma di estensione VSCode installabile direttamente dal marketplace ufficiale e integrato correttamente con quest’ultimo. Ha anche il supporto agli MCP e usa agents.md dentro la directory in cui si esegue per avere istruzioni su come interagire con la codebase.

Backend e architettura: meno ping-pong

Qui il pattern che uso è sempre lo stesso:

- spiego obiettivo e vincoli (compatibilità, tempi, rischio)

- chiedo una proposta a step (incrementale)

- faccio review e solo dopo faccio partire le modifiche

Prompt “da consulente” che mi hanno fatto risparmiare ore:

- “Analizza il repository: colli di bottiglia performance e piano di fix incrementale.”

- “Refactor a layer (dominio/infrastruttura/API) mantenendo compatibilità e note di migrazione.”

- “Bug X: ricostruisci scenario, ipotesi, check rapidi, fix + test.”

Debugging serio: ipotesi → check → fix

Il punto non è “fammi il fix”, ma fammi il metodo a partire da ipotesi ordinate per probabilità, check piccoli e veloci, un fix minimo e una verifica

Ho sperimentato con l’uso della modalità extra high (x-high) che il modello riesce a fare anche ore e ore di reasoning fino al raggiungimento del successo. L’ho trovato per fino più efficacie della versione 5.2-codex che invece sembra dare il massimo quando il task è perimetrato e meno libero.

Codex CLI: quando il terminale diventa un agente (con guardrail)

Codex CLI può leggere, modificare e anche eseguire comandi nel repo. Ma qui entra il tema sicurezza: OpenAI documenta modalità e approvazioni, incluso il passaggio a read-only tramite comando di approvazione.

Dual IDE setup: Cursor + VS Code + GitHub Copilot (base universale)

Perché VS Code resta nello stack

VS Code è lo standard operativo: estensioni, compatibilità, abitudini, portabilità tra macchine e contesti di consulenza.

Copilot lo tratto come “motore di completamento + chat rapida”. E lato pricing: GitHub mostra Copilot Pro a $10/mese (per individui) e specifica che è gratis per studenti verificati.

Student Pack: quando il costo scende davvero

Se sei studente verificato, GitHub Education offre l’accesso a Copilot Pro per studenti nell’ambito delle varie opportunità già previste. Tradotto: puoi tenere uno stack “serio” spendendo molto meno, e investire budget solo dove serve davvero.

Sintesi onesta: Cursor è la mia postazione principale. VS Code + Copilot è lo “standard compatibile ovunque”.

IDE agentici 2025: Antigravity e Kiro (per capire dove va il vento)

Non sono stati il centro del mio stack, ma sono importanti perché rappresentano la direzione: IDE sempre più “agentici”, capaci di pianificare → eseguire → verificare.

Antigravity: agent-first (e guardrail obbligatori)

Google presenta Antigravity come piattaforma “agent-first” con una sorta di “mission control” per orchestrare agenti su editor, terminale e browser. Ma nel 2025 sono emersi anche esempi pubblici che hanno riacceso il tema sicurezza: se dai troppi permessi a un agente, può fare danni veri (serve conferma, sandbox, limiti).

L’ho provato poco perché hanno dato dei limiti davvero irrisori con l’uso dei modelli “esterni” a Google. Limiti che comunque risultano scarsi anche se usi solo modelli di casa come le varie versioni di Gemini che in ogni caso non sono riuscito ad apprrezzare nel coding.

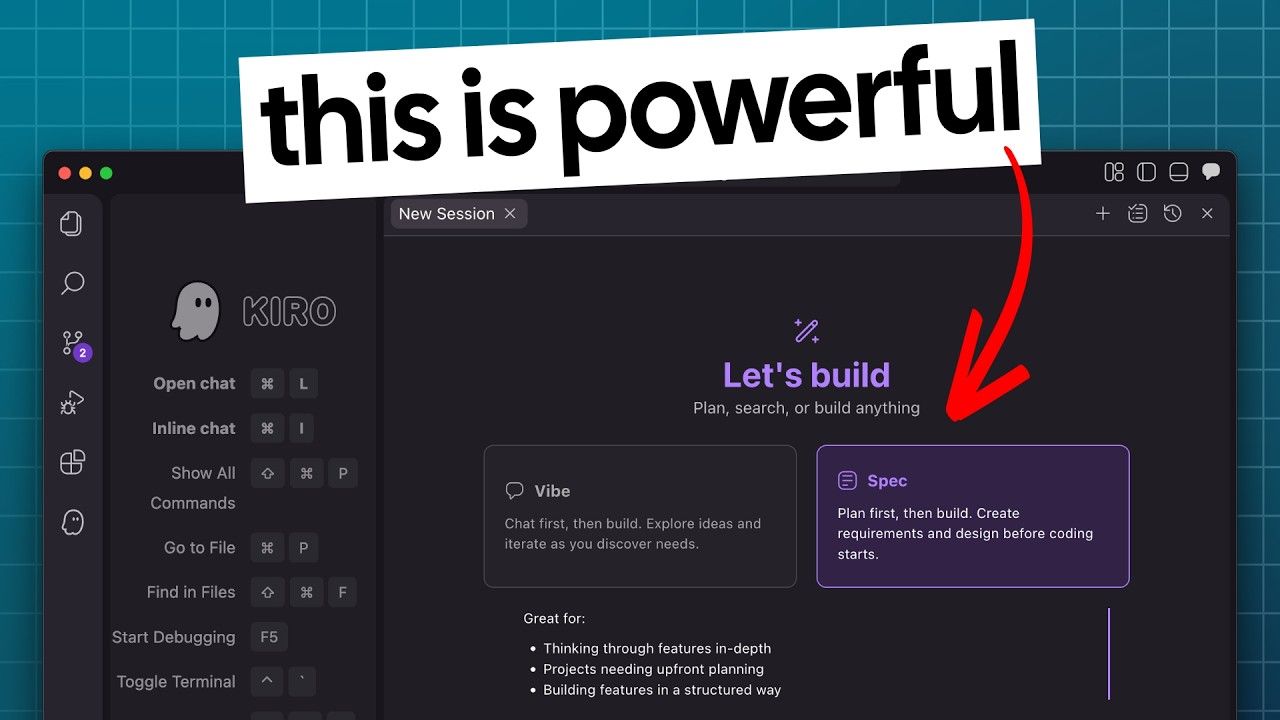

Kiro: spec-driven development (da vibe coding a viable code)

Kiro si posiziona come un IDE agentico orientato allo spec-driven development, con supporto nativo a MCP. È particolarmente interessante in contesti di lavoro strutturati, come i team o i progetti complessi, dove la disciplina di processo è un valore: la spec diventa il primo vero artefatto del progetto e contribuisce a ridurre in modo significativo le ambiguità a valle.

L’ho utilizzato ancora poco, principalmente a causa delle limitazioni del free tier, ma il feedback sul setup iniziale è decisamente positivo. Il flusso di lavoro è solido, guidato e ben orchestrato: segue una logica step-by-step efficace e comprensibile anche senza fornire indicazioni estremamente dettagliate da parte dell’utente.

Si percepisce chiaramente l’impronta metodologica degli sviluppatori Amazon, sia nella struttura proposta sia nell’integrazione tra interfaccia, function calling e documentazione generata automaticamente. È molto probabile che dietro ci sia un livello di prompt engineering sul system prompt estremamente elevato, che rende l’esperienza spec-driven non solo coerente, ma anche sorprendentemente piacevole ed efficace nell’uso reale.

MCP (Model Context Protocol): il pezzo che mi ha fatto fare il salto

Per me MCP è il vero acceleratore perché sposta l’AI da “scrive codice” a “chiude il ciclo”: verifica, misura, aggiorna task, usa docs aggiornate.

Anthropic ha open-sourcizzato MCP a fine 2024 come standard per collegare assistenti a strumenti e dati. OpenAI documenta MCP come modo per dare a Codex accesso a tool e contesto (e cita esempi come Context7 e Chrome DevTools). In generale anche VSCode e Cursor hanno esteso il supporto al massimo sul protocollo permettendo a chiunque di integrarli con una rapidità che non ha eguali. Visual Studio nello specifico ha anche un “marketplace interno” plug and play: installi, attivi, subito disponibile in chat.

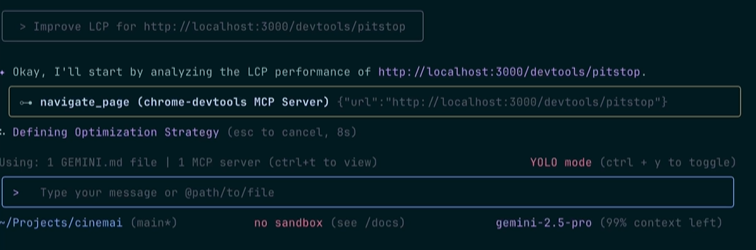

Chrome DevTools MCP: debugging “con gli occhi”

Chrome DevTools MCP si presenta come un MCP server che permette a un agente AI di controllare e ispezionare un’istanza di Chrome live. Non stiamo parlando di analisi teoriche o di deduzioni su codice statico, ma di debugging basato su ciò che il browser sta realmente facendo: DOM, rete, console, performance, tutto osservabile in tempo reale.

È uno strumento particolarmente adatto al frontend, dove il concetto di “dovrebbe funzionare” ha poco valore se non è accompagnato da una verifica concreta. Con DevTools MCP l’agente non si limita a suggerire una possibile soluzione, ma può validarla direttamente nel browser, riducendo drasticamente il gap tra ipotesi e realtà.

Dal punto di vista pratico, i casi d’uso sono molto più ampi di quanto possa sembrare a prima vista.

Puoi usarlo, ad esempio, per verificare in tempo reale le modifiche al codice: l’agente genera una correzione e controlla immediatamente se il comportamento in browser è quello atteso, senza dover alternare manualmente IDE e DevTools. Questo rende il ciclo modifica-verifica estremamente rapido.

Non finisce qui, perché l’agente può analizzare le richieste HTTP, individuare problemi CORS, risposte errate o risorse che non vengono caricate, e allo stesso tempo ispezionare i log della console per capire perché una determinata funzionalità fallisce a runtime.

Un altro aspetto interessante è la possibilità di simulare il comportamento reale degli utenti. L’agente può navigare la pagina, compilare form, cliccare pulsanti e riprodurre bug difficili da intercettare, osservando nel frattempo cosa accade nell’ambiente di esecuzione. Questo è particolarmente utile per testare flussi complessi o condizioni che emergono solo dopo una sequenza precisa di azioni.

Sul fronte UI, DevTools MCP permette anche il debug di problemi di stile e layout in tempo reale infatti, collegandosi a una pagina live, l’agente può ispezionare DOM e CSS, individuare overflow, problemi di allineamento o comportamenti anomali e suggerire correzioni basate sui dati effettivi del browser, non su supposizioni.

Infine, c’è tutta la parte di audit e analisi delle performance. L’agente può avviare una traccia prestazionale, analizzare metriche come LCP o caricamenti lenti e indagare le cause reali dei colli di bottiglia, arrivando a suggerimenti concreti per migliorare i tempi di caricamento.

Il tutto è gratuito, disponibile tramite repository GitHub ufficiale e documentato anche sul blog developer di Google. È uno di quegli strumenti che sposta il debugging da un piano teorico a uno osservativo, meno “secondo me”, più “sta succedendo questo, adesso”.

Prompt tipico per “richiamarlo” in qualsaisi contesto:

Context7 MCP: documentazione aggiornata dentro il prompt

Context7 porta documentazione e snippet versionati direttamente nel prompt (riduce API inventate/outdated).

Esempio:

La mia regola: modello giusto, posto giusto

Nel tempo ho finito per strutturare un vero e proprio mini decision tree operativo, che applico in modo abbastanza sistematico in base al tipo di attività che devo affrontare. Per i task ripetitivi o a basso carico decisionale mi affido ai completamenti direttamente nell’IDE, usando Copilot o il Tab di Cursor, che mi permettono di andare veloce senza interrompere il flusso.

Quando lavoro sul frontend e ho bisogno di verifiche puntuali sul comportamento dell’interfaccia, la combinazione Cursor + Chrome DevTools tramite MCP è quella che mi dà il miglior equilibrio tra velocità e controllo. Le attività più pesanti sul backend come ragionamenti architetturali, refactor strutturali o decisioni che impattano più parti del sistema, le affronto invece con Codex in ChatGPT, all’occorrenza anche via CLI, perché mi consente di alzare il livello di astrazione e ragionare con più calma.

Per tutto ciò che riguarda documentazione nuova o librerie in rapido cambiamento, Context7 via MCP è diventato il riferimento principale perché riduce drasticamente il tempo perso a inseguire esempi obsoleti o API non più valide. Infine, sulla parte di delivery e coordinamento del lavoro, Linear MCP mi aiuta a mantenere allineati contesto tecnico e avanzamento operativo, senza dover continuamente cambiare strumento.

Effetto collaterale positivo: prevedibilità. Tempi più stabili e spesa meno “a sorpresa”.

Guardrail pratici (che mi hanno evitato guai)

- Read-only di default quando uso un agente in terminale su repo sensibili

- Approva solo step piccoli (un commit per volta)

- Limita i tool (MCP server necessari, non “tutto acceso”)

- Log e diff: se non riesci a ricostruire cosa ha fatto l’agente, stai già perdendo controllo

Workflow completo: codice → verifica → task (in 30 minuti)

Ecco un flusso tipico “da consegna” (frontend + bug):

- Riproduco il problema e definisco criterio di successo (es. “login ok, nessun errore console”)

- Cursor: @mention dei file giusti (form, auth service, route)

- Fix minimo proposto dall’agente + review manuale

- Chrome DevTools MCP: verify (network, console, performance)

- Context7 se scopro API nuove o una libreria aggiornata

Questo è il “loop chiuso” che nel 2025 mi ha fatto consegnare più serenamente.

Glossario per chi inizia (senza perdersi)

| Parola | Significato semplice | Perché ti serve |

|---|---|---|

| IDE | Editor avanzato per codice | È il tuo ambiente |

| Repo | Progetto versionato (Git) | Tracci cambi (tracking modifiche) e collabori |

| Branch | Linea di lavoro separata | Non rompi "main" |

| PR | Richiesta di merge | Review e qualità |

| Debugging | Trovare e risolvere bug | Skill base |

| Refactoring | Migliori codice senza cambiare feature | Progetto sano |

| Frontend | UI e interazioni | Browser, UX |

| Backend | Logica e dati | API, DB, auth |

| MCP | Collegamento AI→tool esterni | Verifica e azione |

| DevTools | Strumenti del browser | Console/Network/Performance |

FAQ

Devo scegliere tra Cursor e VS Code?

No. Il setup “dual IDE” funziona: Cursor come postazione principale, VS Code come standard universale per clienti/team.

Codex è davvero incluso nei piani ChatGPT?

Sì: la guida ufficiale indica l’uso di Codex con piani ChatGPT (Plus, Pro, Business, Edu, Enterprise) e l’uso tramite client come Codex CLI. Confermo quanto specificato e aggiungo che i limiti su Codex anche col piano base sono difficili da raggiungere anche se si usa GPT 5.2 Extra high

Quanto costa “il minimo sindacale” per uno stack decente?

Esempio realistico (mensile):

- Cursor Pro $20

- ChatGPT Plus $20 (per Codex) Totale: $40/mese circa, poi aggiungi Copilot solo se ti serve o se non hai già un vantaggio studenti.

Copilot vale ancora la pena nel 2025?

Per me sì, soprattutto per completamenti e compatibilità. E Copilot Pro è indicato a $10/mese, con gratuità per studenti verificati.

MCP è difficile da usare?

Il concetto è semplice: è uno standard che collega modelli e tool. La difficoltà vera è scegliere pochi server utili e mettere guardrail. Prova a vedere se ne trovi qualcuno valido qui.

Quali MCP server consigli “per iniziare” da frontend dev?

Tre: Chrome DevTools MCP per verificare in browser, Context7 per docs aggiornate, Linear/Clickup/Altro per task/issue.

Qual è l’errore più costoso che hai visto fare?

Lasciare un agente “full-auto” senza confini: iterazioni infinite, comandi pericolosi, costi che salgono. Le modalità di approvazione/read-only esistono proprio per questo.

Antigravity e Kiro sostituiscono già uno stack classico?

Sono segnali forti del trend “agentic IDE”, ma oggi (ancora di più nel 2025) io li vedo come strumenti da valutare con calma e guardrail robusti.

Lo stack AI è diventato una scelta di prodotto

Nel 2025 ho smesso di cercare “l’IDE perfetto” e ho iniziato a costruire uno stack coerente:

- un IDE principale (Cursor)

- un agente forte per task complessi (Codex in ChatGPT)

- una base universale (VS Code + Copilot)

- connettori MCP per chiudere il loop tra codice, verifica e delivery

Se vuoi “personalizzarlo” sul tuo caso (freelance vs team, budget, stack React/Next/Node/Python), la regola resta sempre la stessa: meno tool, più flusso, più guardrail.

Grazie per aver letto questo articolo