DeepSeek V4: Il risveglio del Dragone che distruggerà il monopolio della Silicon Valley

L'industria globale dell'intelligenza artificiale attraversa una fase di profonda turbolenza e ridefinizione dei propri paradigmi fondamentali. L'attenzione del panorama tecnologico mondiale è catalizzata dall'imminente rilascio di DeepSeek V4, il modello di frontiera di quarta generazione sviluppato dall'omonima azienda cinese con sede a Hangzhou

Il "Momento Sputnik" del 2026 e la ghigliottina algebrica

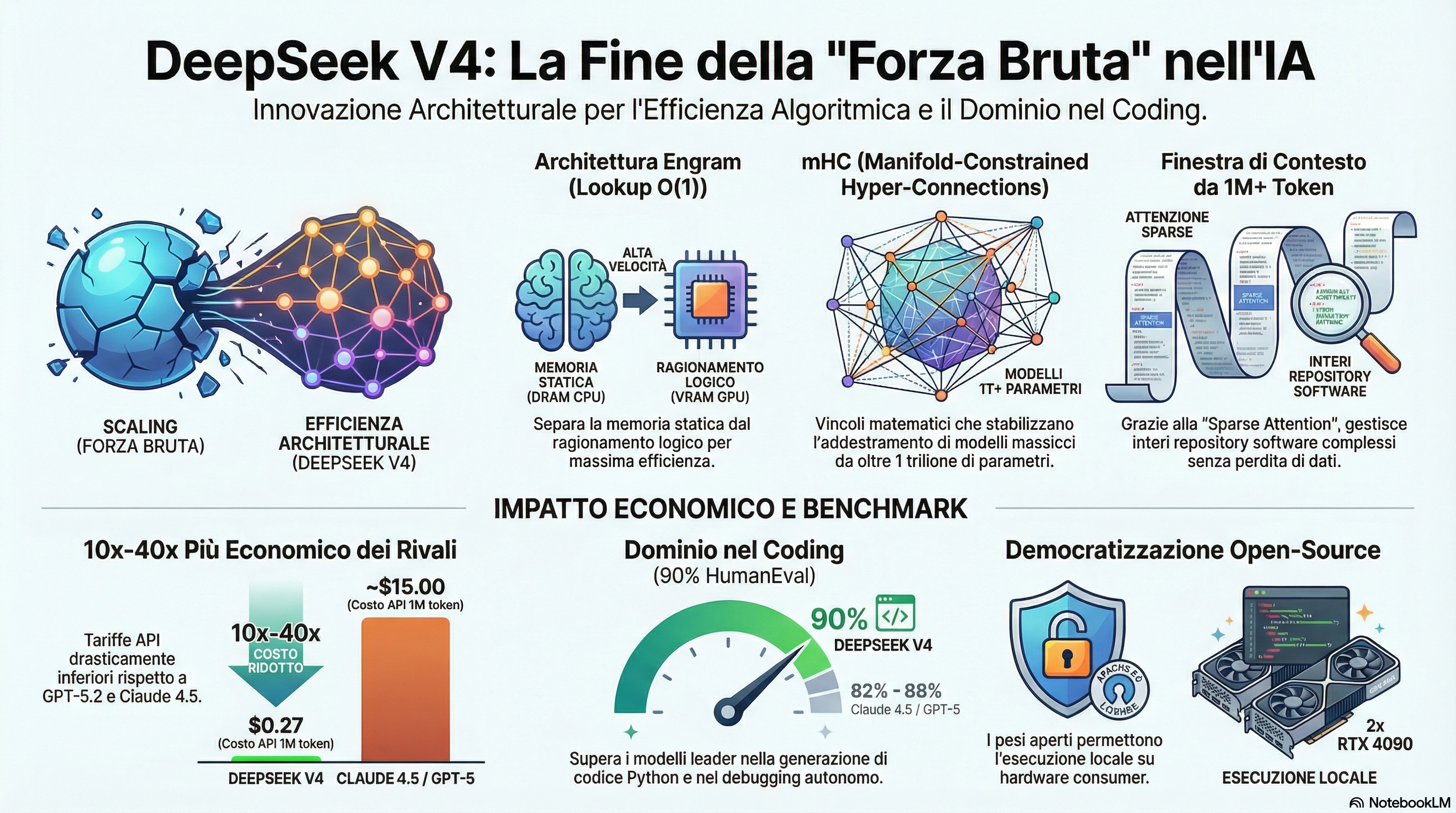

Mentre l'Occidente si crogiolava nella convinzione che l'intelligenza artificiale di frontiera fosse un club esclusivo per miliardari, il Capodanno Lunare del 17 febbraio 2026 ha calato una "ghigliottina algebrica" sui margini della Silicon Valley. Il rilascio di DeepSeek V4 non sarà un semplice aggiornamento incrementale, ma un terremoto sistemico che snacirà (probabilmente) la fine della "muscle head era". Mentre i giganti di San Francisco bruciano centinaia di miliardi in Capex per alimentare supercomputer mastodontici, gli ingegneri di Hangzhou hanno dimostrato che l'eleganza matematica può surclassare la forza bruta computazionale. Non è più una questione di chi ha più silicio, ma di chi possiede la logica più affilata.

Il Leak "MODEL1" e l'architettura Engram

Il cervello con memoria esterna

Il velo su V4 è caduto ancor prima del lancio ufficiale, grazie a una fuga di dati nel repository GitHub FlashMLA. L'analisi forense su 114 file ha rivelato l'esistenza di "MODEL1", un ramo architetturale che rompe con il passato: le teste di attenzione sono state riconfigurate a 512 dimensioni, abbandonando la struttura asimmetrica di V3.2.

Il cuore di questa rivoluzione è il sistema Engram. Per anni, i Transformer hanno sprecato cicli neurali per "ricordare" passivamente fatti statici. DeepSeek V4 introduce un "secondo asse di sparsità" che separa il ragionamento dinamico dalla memoria enciclopedica.

- O(1) Lookup: Grazie a una tabella di ricerca esterna ospitata nella DRAM della CPU (e non nella costosa VRAM della GPU), il modello richiama fatti in tempo costante.

- Compressione del Tokenizer: Una normalizzazione Unicode NFKC ha ridotto la ridondanza del vocabolario del 23%.

- Context-Aware Gating: Un meccanismo di filtraggio dinamico che "chiude il gate" per sopprimere il rumore delle collisioni di hash, permettendo ai layer neurali di concentrarsi esclusivamente sulla logica pura.

"I modelli linguistici sono stati finora prigionieri di una tensione computazionale tra 'ricordare fatti' e 'ragionare logicamente'. Engram libera il processore dal fardello mnemonico, delegandolo a un'architettura di tiered storage."

Oltre il milione di token

Il "Lightning Indexer" per l'architettura software

DeepSeek V4 non si limita a scrivere snippet; è un architetto software capace di gestire una visione olistica. Grazie alla DeepSeek Sparse Attention (DSA), il modello ha infranto la maledizione della scalabilità quadratica. Utilizzando un "Lightning Indexer", V4 converte la complessità di calcolo in una curva quasi-lineare.

Questo permette una finestra di contesto operativa di oltre 1.000.000 di token "lossless". In una singola sessione, V4 può inghiottire un intero repository software (100.000+ righe di codice), identificando bug "upstream" in file interconnessi o rilevando "dead code" in architetture stratificate che i modelli "cloud-locked" americani non riescono nemmeno a mappare.

La matematica della stabilità: mHC e il politopo di Birkhoff

Scalare un modello verso il trilione di parametri porta solitamente alla "divergenza catastrofica". DeepSeek ha risolto il problema con le Manifold-Constrained Hyper-Connections (mHC). Invece di usare connessioni residue statiche, mHC proietta il segnale sul Politopo di Birkhoff (lo spazio delle matrici doppiamente stocastiche).

Utilizzando l'algoritmo di Sinkhorn-Knopp ottimizzato tramite TileLang e calcolo in FP8, il team ha garantito l'integrità del segnale con un overhead irrisorio del 6,7%.

| Caratteristica | Transformer Tradizionale | DeepSeek V4 |

|---|---|---|

| Meccanismo di Connessione | Residua Statica (Identity Mapping) | mHC (Matrici Doppiamente Stocastiche) |

| Stabilità del Segnale | Rischio di esplosione dei gradienti | Integrità garantita via Sinkhorn-Knopp |

| Context Window | 128k - 200k token | 1.000.000+ token (Lossless) |

| Costo di Addestramento | ~$100M - $500M | ~$10M |

| Impatto sul Ragionamento | Standard | +5/7 punti netti (DROP/BBH) |

NVIDIA per creare, Huawei per servire

L'ascesa di V4 espone il fallimento della "Compute Hegemony" occidentale. Per l'addestramento, DeepSeek ha utilizzato un arsenale di 50.000 GPU NVIDIA, ottenute tramite shell companies nel Sud-Est Asiatico o hoarding pre-sanzioni di chip A100 e H20 depotenziati. La beffa finale? I ricercatori hanno scritto codice assembly PTX personalizzato per estrarre performance dalle H20 superiori ai limiti teorici imposti dai regolatori USA.

Per l'inferenza, tuttavia, DeepSeek è passata agli acceleratori domestici Huawei Ascend 910C. Sebbene inadatti al training per via del software immaturo, questi chip da $28.000 offrono il 60% della potenza di una H100 in fase di deduzione, permettendo a DeepSeek di servire il mondo a costi imbattibili.

Democratizzazione radicale, come avere un TitanoAI nel tuo garage

Il colpo di grazia al business model di OpenAI e Anthropic arriva dai costi. Mentre GPT-5 richiede investimenti stimati in 500M, DeepSeek V4 ha raggiunto la convergenza con soli 10M. Grazie a un'architettura Sparse MoE con routing Top-16, un modello da un trilione di parametri ne attiva solo 32 miliardi per ogni token.

Questo si traduce in costi API di 0,27 per milione di token, contro i ~15,00 della concorrenza. Ma la vera rivoluzione è l'hosting locale: grazie all'offloading Engram, un titano da un trilione di parametri può girare su hardware consumer. Bastano due RTX 4090 o una singola RTX 5090 per gestire privatamente ciò che prima richiedeva un data center.

L'avvertimento di Wuzhen – La fine del lavoro cognitivo?

Alla World Internet Conference di Wuzhen, Chen Deli (Senior Researcher di DeepSeek) ha gelato la platea. Condividendo il palco con i CEO di Unitree (robotica) e BrainCo (interfacce neurali), ha dichiarato che la "fase di luna di miele" della produttività assistita è finita.

Secondo Deli, entro 10-20 anni, l'IA sostituirà integralmente l'intelletto umano strutturato e il lavoro dei "colletti bianchi". In questo scenario, i ricercatori IA non devono più essere ottimizzatori, ma whistleblower ed eticisti della sicurezza, avvertendo i governi dell'imminente collasso dell'attuale paradigma occupazionale.

Il Soft Power del Sud globale

Mentre il Nord Globale (USA, UE, Italia) limita o banna DeepSeek per "sicurezza nazionale", il resto del mondo ha già scelto. Con una licenza open-weights (Apache 2.0) e costi irrisori, DeepSeek è diventato lo standard de facto nelle nazioni sotto embargo o in via di sviluppo.

- Cina: 89% di market share.

- Bielorussia (56%), Cuba (49%), Russia (43%): adozione massiccia per aggirare i servizi cloud americani.

- Africa: diffusione capillare tramite la "diplomazia degli smartphone" e i dispositivi Huawei in Etiopia e Uganda.

L’importanza dei modelli openweight per l’Europa

Per realtà come quelle europee, che spesso devono gestire dati sensibili e affrontare costi di inferenza elevati, l'adozione di modelli aperti permette di affrancarsi dalla dipendenza dai provider cloud americani. Implementare queste tecnologie su infrastrutture locali o data center aziendali non solo garantisce il pieno controllo dei propri dati, ma assicura anche la continuità operativa in caso di disservizi dei servizi esterni. In un mercato dove i modelli cinesi open weight stanno sfidando la supremazia di OpenAI e Anthropic, la possibilità di far girare internamente algoritmi di altissimo livello su hardware proprietario diventa un vantaggio competitivo strategico indispensabile per la sovranità digitale europea.

Considerando che a livello di modelli di frontiera solo Mistral prova a competere con i grandi player, poter sperare in un successo dei modelli open weight è qualcosa a cui puntare per garantire indipendentisimo in un futuro sempre più plasmato da queste tecnologie

Verso un futuro Post-Silicon Valley

I benchmark non mentono: con un punteggio del 90% su HumanEval (superando l'88% di Claude 4.5) e un SWE-bench Verified >80% (che batte il 78.2% stimato di GPT-5.2), DeepSeek V4 ha dimostrato che il fossato di OpenAI non esiste più.

DeepSeek V4 non è solo un modello; è il manifesto di un mondo multipolare dove l'eccellenza tecnologica si progetta con la matematica pura e non si compra con i petrodollari. Siamo pronti per un'era in cui il centro di gravità dell'intelligenza artificiale si è definitivamente spostato lontano da San Francisco?

Grazie per aver letto questo articolo