Kimi K2.5: “visual agentic intelligence” e perché questa release è più grossa di quanto sembri

Kimi (Moonshot AI) ha pubblicato Kimi K2.5 come evoluzione “agentica” e nativamente multimodale (testo + immagini + video), e l’ha impacchettata in modo molto più “prodotto” del solito: non solo weights e benchmark, ma modalità d’uso, tooling da developer, e perfino un pezzo di infrastruttura per ricostruire fiducia nell’ecosistema open-source. Di seguito ti smonto le novità tecniche più importanti (quelle che cambiano workflow, non la solita “+X su un benchmark”).

Non è “solo un modello”: 4 modalità operative (e una cambia le regole)

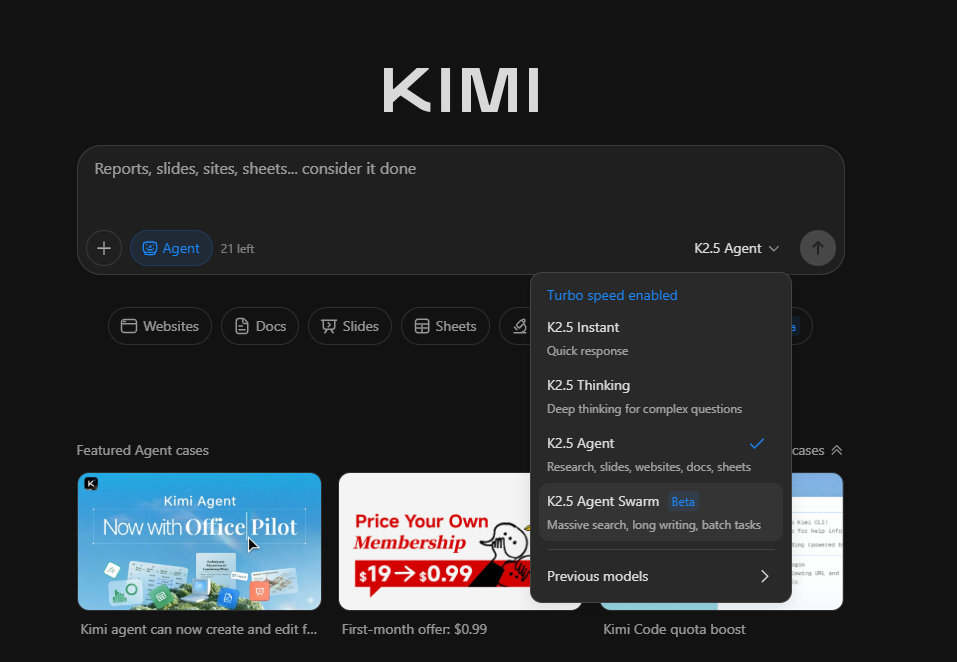

Su Kimi.com e Kimi App K2.5 arriva con 4 modalità:

- K2.5 Instant (risposta rapida)

- K2.5 Thinking (più ragionamento)

- K2.5 Agent (tool-use/azioni)

- K2.5 Agent Swarm (Beta) (multi-agente parallelo)

Questo è importante perché segnala una scelta chiara: K2.5 viene pensato come runtime con profili diversi, non come “un solo LLM e arrangiati”.

Nota pratica già qui: Agent Swarm è in beta e Kimi scrive che i free credits per provarlo sono disponibili per utenti paganti di fascia alta. Tradotto: la parte più “nuova” non è pensata per essere mass-market subito.

“Coding with Vision”: quando l’immagine/video diventa la specifica (e il debug diventa visivo)

La prima novità grossa è l’idea di coding con input visivi:

- image/video-to-code: invece di descrivere a parole una UI, gliela fai vedere (screenshot o video) e chiedi di ricostruirla.

- visual debugging: il modello ragiona su cosa vede (render, layout, output), prova una modifica, ricontrolla, itera.

Kimi porta esempi espliciti: ricostruzione di un sito “da video”, e capacità che derivano da vision-text joint pre-training su scala enorme, con l’idea che “vision e text non si rubano qualità a vicenda” quando sali abbastanza di scala.

Perché questa cosa, da developer, è diversa dal solito “multimodal”

Perché cambia l’input: la specifica non è più solo testo. Se devi fare front-end, spesso la richiesta reale è visiva: spaziature, ritmo delle animazioni, gerarchie, microinterazioni. Quando l’AI può prendere un video come “source of truth”, smetti di perdere mezz’ora a tradurre il visivo in parole.

Kimi Code: il tassello “Claude Code / Gemini CLI” ma con un dettaglio interessante

In parallelo al modello, Moonshot ha rilasciato Kimi Code, un tool per terminale integrabile in IDE come VSCode/Cursor/Zed. La parte davvero interessante (se vera nel quotidiano) è questa: supporta immagini e video come input e dichiara di scoprire/migrare skill e MCP già presenti nell’ambiente di lavoro.

Se funziona bene, è un acceleratore enorme per chi ha già:

- MCP server locali (browser/devtools, repo tools, ecc.)

- toolchain di script interni

- “abilità” operative già in piedi

…perché riduce l’attrito di onboarding: “non devo rispiegare tutto a mano”.

Agent Swarm: “scaling out, not just up” (PARL, 100 sub-agenti, 1500 step)

Qui c’è la seconda botta vera.

Kimi presenta Agent Swarm come passaggio da “un agente più intelligente” a “tanti agenti coordinati”, e dice di averlo addestrato con Parallel-Agent Reinforcement Learning (PARL). Risultato dichiarato:

- fino a 100 sub-agenti

- fino a 1.500 step coordinati

- senza ruoli predefiniti o workflow hardcoded

Questa è una tesi forte: non è tu che disegni la pipeline multi-agente, ma il modello che la autodirige.

Cosa significa in pratica: invece di un agente che fa tutto in serie (ricerca → scrittura → verifica → refactor), puoi avere:

- agente A che esplora alternative,

- agente B che implementa,

- agente C che valida/controlla edge cases,

- agente D che prepara output “presentabile” (doc, slide, ecc.)

…in parallelo. È un salto di throughput, non solo di IQ.

Office productivity “seria”: Word/PDF, pivot, output lunghi

La terza area su cui Kimi spinge è la produttività “da ufficio”, con esempi molto concreti:

- annotazioni in Word

- modelli finanziari con Pivot Table

- equazioni LaTeX in PDF

- capacità di reggere output lunghi tipo paper da 10.000 parole o documenti da 100 pagine

Questa parte è meno sexy ma più monetizzabile: è dove i tool agentici diventano “collega operativo”, non “chatbot”.

La cosa più “matura”: Kimi Vendor Verifier (KVV) e la guerra al “non è lo stesso modello”

Moonshot ha anche open-sourcato Kimi Vendor Verifier (KVV), e qui c’è un messaggio sottotraccia molto chiaro:

Aprire i pesi non basta. Se ognuno hosta il modello con parametri/decoding diversi, preprocessing diverso, bug di KV cache o quantizzazione aggressiva, i risultati cambiano e tu non sai più se il problema è “del modello” o “dell’implementazione”.

KVV nasce proprio per distinguere capacità vs deployment. E cita problemi reali: in thinking mode hanno dovuto forzare temperature e top-p lato API e verificare che il contenuto “thinking” venga passato correttamente.

KVV propone un set di test “mirati” (OCRBench, MMMU Pro, stress test lunghi tipo AIME2025, toolcall consistency, ecc.) e promette un leaderboard pubblico dei vendor.

Per chi lavora con open-source in produzione, questa è una delle parti più utili: riduce il caos del “sì però su provider X va peggio”.

Riproducibilità: contesto 256k e settaggi dichiarati

Nel report Kimi specifica anche dettagli di test (temperatura/top-p) e un context length di 256k token per gli esperimenti K2.5. È un numero enorme lato UX (documenti lunghi, multi-file, ecc.), ma soprattutto è una nota di trasparenza utile.

Come si prova (e la nota sui piani / promo)

Ufficialmente K2.5 è disponibile via Kimi.com, Kimi App, API, e Kimi Code. E la pagina “model overview” di Kimi indica anche accesso gratuito con limiti d’uso.

Detto questo, la parte che tutti vogliono davvero provare oggi (cioè Agent Swarm) è esplicitamente beta e i “free credits” vengono citati per high-tier paid users. Quindi: sì, puoi usare K2.5, ma la feature più nuova non è “free for all”.

Bonus: Google lancia “Agentic Vision” in Gemini 3 Flash (27 Gen 2026)

Quasi in parallelo, Google ha annunciato Agentic Vision in Gemini 3 Flash. Il concetto è molto simile (ed è un segnale di trend): la visione non è più “uno sguardo e risposta”, ma un loop Think → Act → Observe, dove Act significa: il modello scrive ed esegue codice Python per fare crop/rotate/annotate, calcoli, conteggi, ecc., e poi rimette l’immagine trasformata nel contesto per osservare meglio.

Google dice anche una cosa misurabile: abilitare code execution con Gemini 3 Flash dà un boost consistente 5–10% su molti benchmark di visione. Possiamo dedurre davvero che “agentic vision” non è marketing, è l’evoluzione naturale (e ha una genealogia precisa)

Se metti insieme Kimi K2.5 e Gemini 3 Flash, esce una traiettoria chiara:

- Tool-augmented multimodal agents: il passo successivo è rendere normale che un modello manipoli immagini con strumenti (Python, editor visuali, ecc.) dentro un ciclo.

Quindi “agentic vision” è, in pratica, la versione multimodale di una frase semplice: meno “indovina”, più “ispeziona e dimostra”.

E qui il punto finale: quando i modelli iniziano a toccare i pixel (crop, box, overlay) e a toccare l’ambiente (tool, file, documenti), diventano molto più affidabili nei task reali: UI debugging, documenti tecnici, planimetrie, tabelle dense, reportistica, QA visivo. È esattamente la direzione in cui si stanno muovendo sia Kimi sia Google (e non per caso).

Grazie per aver letto questo articolo